关于AI的潜在威胁,在媒体轰炸之下,我们大多人都能说上几条来,比如数据监控,数据造假,不透明性。

但若真是要讲清楚这些名词将如何系统性改变这个社会,尤其是去设想这些威胁具体落在社会的情况会怎样,那可能没有多少人能做得到。

但有两位演讲者做到了。

一个月前,Youtube上线了一条名为《AI困境》的视频,截至今天已经获得136万播放。就在上周,这条视频还累计得到了超过60万次播放。

Tristan Harris和Aza Raskin是人性化技术中心的联合创始人,他们还有个更响亮的名字,“硅谷的良心”。近几十年来,他们一直致力于挖掘科技对社会可能造成的影响,我们如今熟知的“注意力经济”就是通过他们的宣传家喻户晓,他们最知名的成果是Netflix获奖纪录片《社会困境》,这部片子讲述了社交网络和它背后的大公司对人的选择和注意力的控制。

对于AI技术,他们肯定不是最资深的研究员。但最快的去理解和讲述科技对社会的影响,他们是毫无疑问的专家。

因此也就有了这篇接近两万字的演讲,这毫无疑问是截至当下这个时间点最形象,最有说服力的关于AI到底可能如何毁掉人类的文明的分步说明指南。

“推广AI就像你要上一架飞机,50%的工程师说,如果你上这架飞机,每个人都会坠毁的可能性大于10%, 你会上那架飞机吗?”

第一个原因:这是第一次,我看到的人工智能让我感觉,我们越过了一个阈值

第二个原因:我们试图向记者解释正在发生的情况时有一种非常奇怪的体验

这是去年1月份的事情。那时可能只有大约100人在玩这个全新的技术(注:这个技术指Stable Diffusion的图像生成AI技术),现在已经有1000万人使用它生成了超过10亿张图像。我们向记者解释这项技术如何工作:你输入一些文字,它会生成一张以前从未见过的图片。在结束时,记者们会说:“很酷,你从哪个图像数据库获得这些图像?”

很明显,我们像橡皮筋一样拉伸了记者们的思维。然后,因为这是一种全新的能力和全新的范例,他们的思维会弹回来。

即使在多次做这个演讲时,我们也意识到我们必须扩展我们的思维。然后我们看向别处,它就会弹回来。我们只是想给这种体验命名一个名字。因为如果你跟我们一样,在这个演讲结束后回家时,你会说:“等等,我们刚看到什么?”

我认为,因为人工智能是一个如此抽象的东西,它影响着如此多的事情,而且没有以往生活中身体感觉的基本隐喻,所以很难完全理解它有多么变革性。所以,当我们说这次演讲是一个对一种范例性技术的范例性响应时,我们真正想要做的是,让你们所有人有一种更加直观的方式来体验我们即将迎来的指数曲线。

先简单地介绍一下我们的来历,因为我们将说很多关于人工智能并不太积极的话。

其实,自2017年以来我一直致力于一个名为“针鼹计划”的项目,使用人工智能翻译动物交流,解码人类(和动物交流的)语言,这其中有许多我真正喜欢和相信的的东西。

几周前,我用ChatGPT为自己做了一个西班牙语导师,花了15分钟。我们并不是在说它比Duolingo好(笑)(注:Duolingo,美国一个语言学习网站及app)

我们并不是说这些技术不会带来令人难以置信的积极影响,这不是我们要说的;我们要说的是,我们现在将这些新的大型语言模型人工智能释放到公众领域,是否以一种负责任的方式这样做?

我个人的感觉是, 这就像1944年,你接到了罗伯特·奥本海默的电话,他在负责这个被称为曼哈顿工程的东西。你不知道那是什么,他说世界即将以一种基本方式改变。除了,这种改变的方式不是以安全负责的方式,而是以非常危险的方式部署的。

我经常说,这更像是一个担心这个问题的大量人群的隐喻。其中一些人可能在这个房间里,他们是这个行业里的人。我们想弄清楚责任看起来像什么。

为什么我们会这么说?因为这个统计数据让我感到惊讶:

50%的人工智能研究者相信,有大于10%的可能性,人类将因为无法控制人工智能而灭绝。

再说一遍,一半的人工智能研究者相信,有大于10%的可能性,人类因为无法控制人工智能而灭绝。

这就像你要上一架飞机,50%的工程师说,如果你上这架飞机,每个人都会坠毁的可能性大于10%, 你会上那架飞机吗?

但由于我们将要讨论的一些动态,我们正在迅速将人们载上这架飞机。

第一,当你发明一项新技术时,你会发现一种新责任,这些责任不总是明显的。

举两个例子,在电脑能永远记住我们之前,我们不需要将被遗忘的权利写入法律,这一点都不明显;廉价的存储意味着我们必须发明新的法律。

在大规模生产的相机进入市场之前,我们不需要将隐私权写入法律。布兰代斯实际上不得不从零开始发明隐私权,这原本不在原始宪法中。

当然,稍微向前跳一下,还要关注经济学,我们仍在努力寻找如何将从经济学出发把从我们这里带走的权利写入法律。

如果不协调这场竞赛,最终会以悲剧结束。没有一个单一的参与者能停止这场以悲剧结束的竞赛,这就是《社会困境》(这两位制片人打造的Netflix获奖纪录片)所要表达的。

我很好奇这是否对你有意义,因为当你打开TikTok并滚动手指时,你就激活了那台针对你大脑计算和预测的超级计算机人工智能,它以越来越高的精度计算出完美的内容,让你持续向下滑(浏览内容)。

这是我们已经拥有的每天都在使用人工智能,这是一种非常简单的技术,它只是计算要显示给你的大脑神经系统的照片和视频,让你持续向下浏览。

尽管,这种相对简单的技术,相当于人类对人工智能的第一次接触, 已经足够破坏人类,造成信息过载,成瘾、厌世滚动、儿童性别化、注意力持续时间缩短、极化、假新闻和民主的崩溃;但是,没有人希望让这些事情发生。

只是有一群工程师说,我们试图最大限度地(让用户)参与其中,这似乎是无害的,而你在YouTube上得到的推荐越来越个性化,YouTube的人并不知道这会导致互联网上不同的(信息)兔子洞。

我们会讨论,在第二次与人工智能的接触中会发生什么。我们也会从这项技术中获得很多好处。我们也将讨论一场大家容易记住的竞赛。

再解释一下,第一次 (AI的)接触是定制人工智能(注:即推荐算法),第二次接触是创造人工智能,和生成式大模型等。

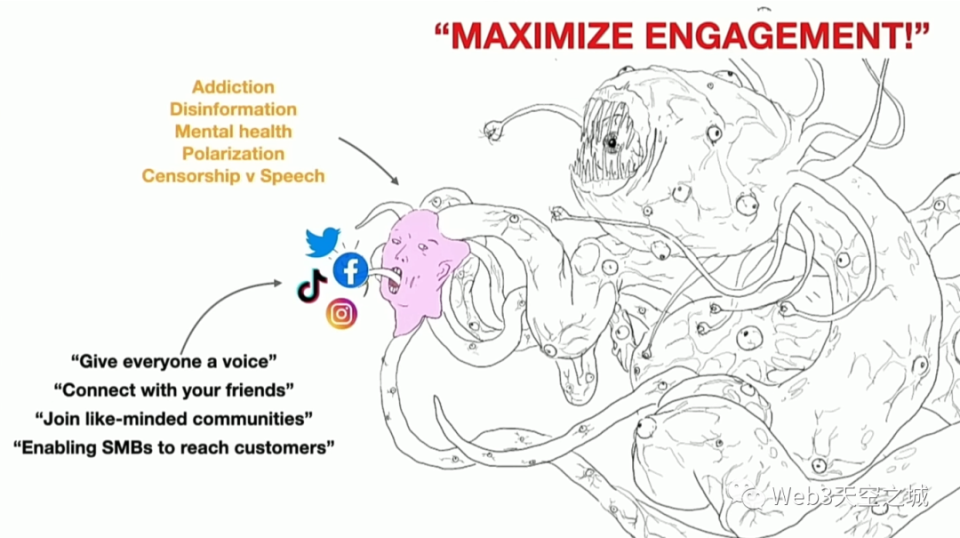

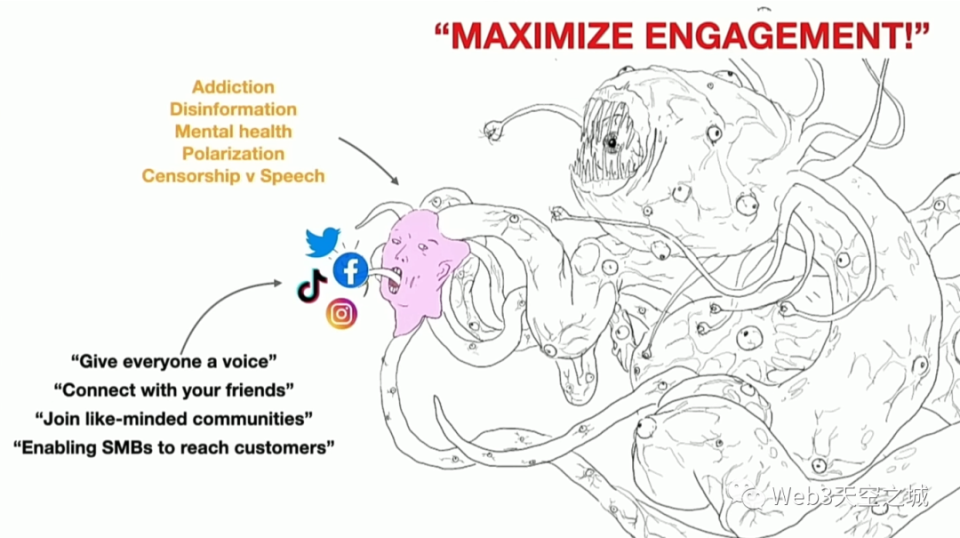

我们(在纪录片里 )说了很多关于社交媒体的事情。这里的要点是,就像我们提到的那样,人工智能有一种范例性反应。我们看到的社交媒体的范例是什么?

这个范例是,我们给人们一个发言平台,我们连接人与朋友,我们让人们加入志同道合的社区,我们将使中小型企业能够接触其客户。

这些说法都是正确的,这些都是真实的好处,这些说法并没有错误。

但我们经常说,在这张友好的面孔后面,还有其他问题。人们已经指出,我们有成瘾问题、误信息问题、心理健康问题、言论自由与审查之间的问题。如果你一直在关注我们的工作, 这一切都在《社会困境》中。

我们说,甚至在这些问题背后,实际上还有更深层的问题,那就是我们谈到的技术第三条法则中的军备竞赛。

这场军备竞赛是为了获得关注,这变成了对大脑干细胞(成瘾性)的竞赛。这创造了一种致力于最大限度提高用户参与度的人工智能。

虽然这些内容看起来是正确的,但我们错过了更深层的范例。所以,如果我们想预测这些将融入社会的其他人工智可能会发生什么,我们必须理解我们谈论它们的方式,以及背后的真正内涵。

请注意,如果你试图独立解决这些问题,如成瘾、误信息和心理健康,你就是在玩捉迷藏,你不会解决问题的根源。

值得注意的是,最大限度提高(用户)参与度实际上改写了我们社会的各个方面,因为它将我们社会的其他核心方面纳入其触手之中,然后占据和掌控它们。

现在,儿童的身份被掌控在是否拥有Snapchat账户或Instagram账户上。如果你18岁没有这些账户,你就不存在;如果不这样,就相当于被社会排斥;媒体新闻业也无法在Twitter之外存在,或不能在Twitter之外宣传自己;国家安全现在是通过社交媒体和信息战进行的;政治和选举现在也是通过这种参与经济运行的。

这就是为什么现在要管制它变得如此困难,这也是我们称这一时刻为重要转折点的部分原因。

我们相信人工智能的重大转变即将来临,我们想在它融入我们的社会之前解决这个问题。在与GPT-3的(人工智能)第二次接触时,首先要注意的是,我们是否已经解决了社交媒体的错位问题?不,我们没有解决,因为它已经融入进去了。

现在,如果我们谈论第二次接触时刻,即GPT-3这些新型大型语言模型,我们会先讨论现在我们正在谈的是什么。

我们说人工智能会让我们更高效,它会帮助我们更快地写东西,更快地编写代码,解决不可能的科学难题,解决气候变化,并帮助我们赚很多钱。

这些说法都是正确的,这些都是真实的好处,都是真的将要发生的事情。

同时在这之后,我们又看到了这张奇怪的可怕的面孔,我们担心人工智能偏见,担心它会夺走我们的工作,我们需要透明度。在所有这些背后,有另一种怪物,这个怪物是一个集合,AI已经在一起协同发展,这个怪物正在增加其能力。我们担心它将再次与社会纠缠在一起。