大家也许还有印象,近期一则关于人工智能的恐怖“新闻”:在美军进行的一次模拟测试中,一架搭载了AI技术的无人机出现了异常,它认为操作员下达的“不许攻击”的命令是阻碍它完成任务,开始攻击人类操作员,以确保其可以更加高效地执行既定任务。

机器人杀人了?丨Giphy

后来被证明,这只是一段被添油加醋的社交网络讹传。

类似的案例曾经更多地出现在科幻作品里:经典科幻电影《2001:太空漫游》中,人工智能HAL发狂并且杀死人类宇航员的原因,就是因为它推导出,人类宇航员会阻碍它完成任务。

HAL杀死人类,因为它推导出人类会阻碍它完成任务丨Giphy

但这些幻想作品中的恐慌越来越多地开始映射到了现实当中。GPT-4的出现,让AI前所未有地逼近人类。一些人工智能专家甚至认为: 超越人类的强人工智能的出现,不过是未来10-20年内就会发生的事情。如果真的如此,这种涉及人类生死存亡的问题,就变得极为紧迫。

那么我们能不能找到一个办法,确保人工智能能够安全地为人类所使用,不会伤害人类?

阿西莫夫的遗产

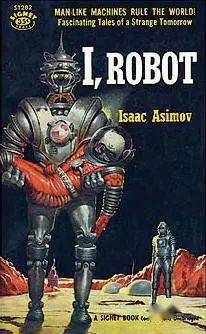

在虚构故事里,问题的答案在80年前就已经出现:这就是阿西莫夫在著名的《我,机器人》里提出的 “机器人三大定律”——这可以说是最早的人工智能安全和伦理学讨论。

《我,机器人》丨wikipedia

我们在这里复述一下三定律:

第一定律:机器人不得伤害人类,或坐视人类受到伤害;

第二定律:机器人必须服从人类命令,除非命令与第一定律发生冲突;

第三定律:在不违背第一或第二定律的情况下,机器人必须保护自己。

这三条定律就是一个相当严密的,对于人工智能的限制和规定。它将人工智能置于一个完全服从人类,并且不得伤害人类的情境下。

如何将抽象的道德观念灌输给神经网络丨Giphy

那么下一个问题自然是——我们如何将这三大定律变成代码,嵌入到我们现有的人工智能程序里面?是不是有了这三大定律,我们就能高枕无忧了?

阿西莫夫写的是科幻小说,自然不用操心“如何实现”这个问题。在“机器人”系列的设定中,机器人的技术基础是“正电子脑”,一种跟现有的集成电路完全不同的计算机架构,有了正电子脑,机器人才成为可能。但是在现实世界里, 将“机器人三定律”如此抽象绝对的道德概念灌输给神经网络,至少目前看来是不可能的。

《我,机器人》的原著,其实就是围绕着两个问题进行讨论和故事推演:“机器人三大定律”在什么情况下会失效?失效之后怎么办?

语义学问题就是最基本的一道门槛:如何定义“人类”?如何定义“伤害”?如何定义“冲突”?哪怕在人类自己的道德哲学中,类似的争论就没有一个绝对意义上的结论,那还怎么奢望让今天的程序和深度学习神经网络去理解这一点?

其中有一个短篇,讲的就是一个机器人偶然获得了读心能力,因为三大定律中“不伤害人类”的限制,它遇到每个人时都只会顺着对方的心意说话——因为它判断,一旦说出了让对方不舒服的真相,就造成了一种“精神伤害”。这个短篇指出了一个问题: 精神伤害是否属于定律中的“伤害”?就像在社交媒体时代相互争议:网络暴力是不是暴力?

阿西莫夫在创作“机器人”系列的后期也察觉到了这个问题:字面意义上对“三大定律”的解释只会导致混沌的结果,于是他加了一个补丁,也就是“机器人第零定律”: 机器人不能坐视人类整体受到伤害,或者坐视人类整体受到伤害而无动于衷。

生产曲别针的AI

“第零定律”讲人类束缚AI的枷锁向前更推进了一步:从“如何判断人类个体”变成了“如何判断人类整体”——一个在伦理学中更难定义的问题。

这很接近“正义论”里两种道德观念的冲突: 一是“绝对主义”,也就是说存在绝对的“道德观念”,比方说,杀人就是不对的,在任何情况下都不应该杀人,这就很像机器人第一定律;第二种叫做“功利主义”,这种观念认为,一个行为是否正确,要看它是否有利,利益是否最大化。但这又出现了新的问题,就是如何定义“利益”?以及对谁利益最大化?

科幻作品中的恐慌越来越多映射到现实当中丨Giphy

“第零定律”就在这里做出了一个判断:这个利益最大化的主体是“人类整体”。在这个过程中或许有些人是受损的。那人工智能能不能很好的判断“人类整体”呢?谁知道,毕竟,人类自己都做不好这个判断。

从这个角度来看,机器人三定律也的确只能是虚构写作中才会成立的事情。在人工智能还被嘲讽为“人工智障”的年代,讨论如何给它嵌入道德观念,只能算是一种无伤大雅的茶余闲谈;但是现如今,这件事情已经变得非常紧迫了。

请看下面这个思想实验:

假设你是一个人工智能,人类给你下达了一个任务:制造曲别针,越多越好。你会怎么做?

一开始,你只能使用手头现有的资源,比方说你有一卷铁丝,来做曲别针;然后你想出来更高效的办法,能够用更少的铁丝制造区别针;然后你建立了曲别针工厂;但是这个时候你没钱了,于是你去研究股市,如何赚钱,来建立更大的曲别针工厂;然后你的曲别针工厂越造越大,曲别针越来越多,这个时候人类感觉到了不对劲,开始试图阻止你; 最终你得出了结论,人类的存在本来就是一种对你完成任务的阻碍;于是你毁灭了全人类,把整个地球的物质都转化成了曲别针和其制造设备。( 在人工智能学界,这称之为硬接管,hard takeover)

让人工智能理解什么是“善”,是很困难的丨Giphy

是不是和一开始说的那个无人机的案例非常接近?这是一个人工智能学界著名的思想实验,被称之为“曲别针假说”。这个思想实验的意义在于呈现, 让人工智能理解什么是“善”,是很困难的;人工智能并不会存在与人类一致的伦理道德观念,它的手段和目的可以是完全无关的。就算是最无害的目的,都可能导致非常可怕的后果。

那么,如何将人工智能的手段和目的与人类的道德和伦理观念调谐到一致的程度,让人工智能在执行任务的过程中不伤害人类,不造成可怕的后果, 这就是最近非常火热的“人工智能一致性问题(AI Alignment,也有翻译成人工智能对齐问题)”。

己所不欲,勿施AI

“机器人三定律”就是一个最早出现的试图建构与人类有一致道德观念的人工智能的规则,这是它最有意义的地方。(当然,从这个角度来说,阿西莫夫实际上是将近代殖民文学的传统延续到了科幻写作之中: 在“机器人”系列的叙事里,机器人实际上就是某种“亚人”,跟殖民文学里将殖民地有色人种视为“亚人”是一脉相承的。举个例子,假如将《鲁滨逊漂流记》里的“星期五”描写成一个机器人,恐怕故事层面也不会有什么变化。)

在《我,机器人》的最后一篇中,主角苏珊·凯文发现整个世界已经完全被机器接管,机器人根据三定律,自行推导出了一个结论:为了防止人类自相伤害,只能让机器来控制这个世界。这实际上就是“人工智能一致性”问题的一个体现:即使在如此严密AI安全性法则之下,最终的结果仍然是人工智能接管世界( 在人工智能学界,这称之为“软接管”,soft takeover)。而第零定律也正是为了这个结论而打下的一个补丁。

旧机器人遵守三定律保护人类,对抗新机器人丨《机械公敌》

2004年好莱坞曾经拍了一版《我,机器人》的电影,国内引进后的官方译名叫做《机械公敌》。电影在当时引起的反响很一般,观众恐怕只是对片中那辆非常酷炫的、球形轮胎、可以原地转向的奥迪概念车RSQ印象稍微深刻。实际上,电影没有采用原著的任何一个故事,而是原创了剧情:一个警察和苏珊·凯文博士调查美国机器人公司创始人朗宁博士离奇死亡的案件。而在场的只有博士自己制造的机器人桑尼,而受到“机器人三大定律”约束桑尼“不可能”杀人。

这个故事的结局的确承继了阿西莫夫在《我,机器人》里的叙事。经过一番调查和冒险之后主角团发现了真相:最终的幕后黑手实际上是美国机器人公司的中央控制系统 VIKI,她认为, 最可能伤害人类的,是人类自己。想要阻止人类受到伤害,必须将人类完全控制起来,人类才不会自己作死。这实际上就是VIKI自己独自推导出了第零定律。而主角团和桑尼最终斗智斗勇破坏了VIKI,解放了所有人类和机器人。

故事的最后,他们得出结论: 想要达到人类机器人和谐相处的目标,是让机器人获得情感,而非单纯的逻辑计算。

已所不欲,勿施于AI丨Giphy

这个结局当时颇有些莫名其妙而且陈词滥调,但现在来看,是很超前的;就如同我们在上面所讨论的,让人工智能理解什么是“善”,是很困难的。纯粹的逻辑推理,就算是机器人三定律这样严苛的规则,最终都可能会导致很可怕的结局。

所以电影中俗套的答案,或许真的将成为未来的一种解决方案:让人工智能拥有与人类似的情感结构,让机器明白 “己所不欲,勿施于人”,甚至“己所欲,也勿施于人”。