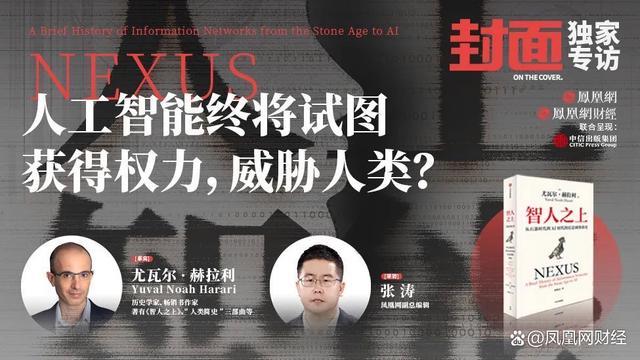

近日,凤凰网财经《封面》与历史学家、哲学家,《智人之上》、“人类简史”三部曲等书作者尤瓦尔·赫拉利展开了一场深度对话。针对人工是否比核武器更危险的问题,尤瓦尔·赫拉利表示,核武器的风险从一开始就显而易见。只有一种非常危险的情况——核战争,每个人都能轻易想象。有了人工智能,一些危险的场景也很容易想象。例如,如果某个暴君让人工智能控制其国家的核武器,然后人工智能犯了一个灾难性的错误,会发生什么?或者,如果恐怖分子利用人工智能制造一种新病毒,引发一场大流行/瘟疫,会发生什么?

然而,人工智能也存在许多难以想象和预测的危险场景。产生这种威胁是人工智能的本质,因为人工智能有能力自己做决定,自己发明新想法。最初的确是人类工程师设计了人工智能,但人工智能可以自己学习和改变,并开始做人类工程师没有预料到的事情。如果一个计算机程序不能自己学习和改变,它就不是人工智能。

尤瓦尔·赫拉利指出,当数以百万计的非人类代理人开始做与我们相关的决定,并创造新事物——从新药到新武器,从新艺术品到新货币——我们的社会将会发生什么?我不害怕科幻小说中的场景,比如一台电脑决定杀死所有的人类并接管世界。这是极不可能的。相反,我担心的是由数百万人工智能管理的新帝国的崛起,它们将能够消灭隐私,随时监控每个人,并为了一小部分精英的利益而剥削大部分人。

© 版权声明

文章版权归作者所有,未经允许请勿转载。